近日,浙江数字化发展与治理研究中心研究员、浙江大学管理学院教授王明征(通讯作者)及其团队在《管理工程学报》发表论文《人工智能使能系统的可信决策:进展与挑战》。该文从人工智能使能系统决策事故的频发,引出是什么导致人工智能决策的信任危机、人工智能使能系统决策如何才能可信这一问题,进而提出一个贯通人工智能系统生命周期的人机协同可信决策框架。

【作者简介】

王明征,浙江数字化发展与治理研究中心研究员,浙江大学管理学院教授,博士生导师,博士;研究方向为数据驱动决策、大数据解析与统计优化等。

【研究缘起】

人工智能(artificial intelligence, AI)技术已经成为新一轮科技革命和产业变革的核心驱动力,中、美、欧、日等世界主要国家和地区均将AI技术的发展列为国家的重要发展战略。利用AI代替人类处理海量数据并迅速做出高精度的预测和决策任务,可以大大提高决策效率,降低人力成本,促进生产力的提升。近年来,智能决策应用迅速渗透至各个领域,对人们日常生活和社会经济发展产生了重大影响。然而,在成功的AI决策应用为人民生活创造便利,为社会发展创造价值的同时,AI使能系统决策事故的频繁出现,也令高风险领域的AI决策引发全球的信任危机。

例如,在2021年7月至2022年5月期间,12家公司向美国国家公路交通安全管理局(NHTSA)报告了无人驾驶的367起碰撞事故,其中有11次发生严重伤亡;大名鼎鼎的IBM Watson Health经常给出错误的癌症治疗建议,还为已经大出血的癌症病人开出了可能导致出血的药;美国司法判决在利用COMPAS AI犯罪风险评估算法时出现了对黑人的系统性歧视偏见;谷歌的广告算法展示给女性用户的招聘职位要比展示给男性的待遇低等。这些高风险领域的失误令人难以信任人工智能决策,因为AI在统计层面上0.01%的错误概率,发生在每个个体上都是100%的不可承受之痛。基于此,学者和业界人士逐渐认识到,AI决策信任被不可解释、不可问责、种族/性别歧视、隐私泄露等黑云笼罩着。任由不可信的AI决策继续发展,将会造成不可估量的生命财产损失和严重的社会影响。

那么究竟是什么导致了人工智能决策的信任危机?人工智能使能系统决策如何才能可信?这一关乎人工智能使能系统落地应用的世界性难题,激发了监管界和学术界的极大关注。

【问题结构】

(1)哪些风险导致了AI使能系统决策的信任危机?

为了解决这个问题,需要分析AI使能系统决策的风险来源。文章探究视角主要来源于自身的内生性风险以及在人机交互中的信任问题两个方面。前者主要是模型角度和数据驱动的内生风险,包括AI模型黑盒特性导致的不可解释风险与不可问责风险,以及数据偏差导致的不公平风险和数据安全引发的不可靠风险等四个方面;后者是需要委托人工智能进行直接决策或者采用人机协同决策时产生的信任风险。上述这些风险共同影响了用户对AI系统的采纳和决策的信任。

(2)哪些要素可以让AI使能系统的决策可信?

针对人工智能使能系统可信决策的理论研究最早从可信AI系统的设计原则上开展,期望从宏观方向上指导AI应用向着可信的方向发展。可信的AI决策通常需要两方面的准则,一是功能性准则,要求AI系统在技术和功能上可信,即要求AI模型具有较高的准确率、鲁棒性和安全性等,这是AI应用的共识前提。二是伦理性原则,要求AI系统决策过程中符合伦理道德标准,才能得到人类的信任。其中,可解释性、公平与偏见、安全与隐私性和可问责性是当前业界达成共识的最重要的四个原则,这也与上述风险紧密相关。然而,这些伦理原则之间的优先级关系和内部边界还没有清晰地界定。围绕人工智能使能系统的AI模型、大数据和人机交互等关键要素,如何实施这些原则有许多值得探讨的问题和需要的解决路径。

【研究框架】

针对存在的AI决策信任危机和风险问题,文章在梳理众多相关研究文献的基础上,从模型、数据、信任三重重要的视角系统分析了人工智能使能系统可信决策的研究进展。从模型的可解释性和可问责性、数据的公平性和安全性和用户对AI信任五个维度对相关研究方法和应用进行了综述分析,并按照风险来源、伦理性准则和行业应用的角度进行归纳,对可信AI的行业异质性和共性规律做出分析。进而,从管理视角出发,提出了多重不确定情境中AI使能系统可信决策的挑战问题,以及贯穿人工智能系统生命周期的人机协同可信框架。最后,对AI使能系统可信决策的未来发展进行了展望,希冀对人工智能使能系统的可信决策研究提供更多的理论和实用价值。

【引领启迪】

第一,从模型、数据、信任三个视角对AI使能系统的可信决策的国内外研究最新进展进行了梳理,一定程度上弥补了现有研究对AI可信决策的原则在理论与实践之间的鸿沟,为当前AI使能系统的可信决策研究的推进提供了崭新视角,帮助感兴趣的研究人员有效地把握该主题的关键方向,为从事相关领域学者的研究工作提供方向性的引领思路。

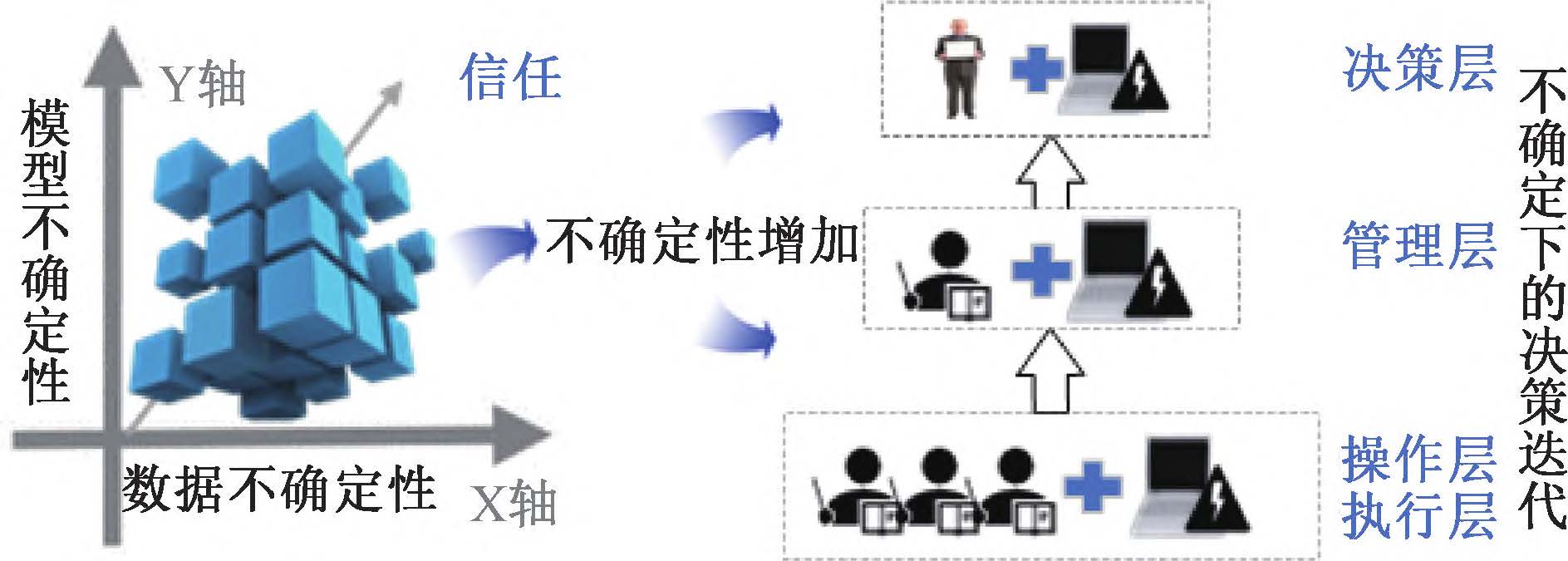

第二,从管理视角提出了多重不确定情境中AI可信决策的挑战,包括对AI的持续信任、多重不确定性和新型人机协同团队的决策模式等。本文认为,如何组建可信人机协同团队、跨组织的可信决策问题将是人工智能使能系统可信决策未来发展的挑战问题。

不确定性增加与人机协同中的决策迭代

第三,提出了贯穿人工智能系统生命周期的人机协同可信框架。从AI使能系统的主要参与者之间的协同交互出发,将AI可解释性、公平性、安全隐私性、可问责性以及可信组件在一个连续有机的整体系统框架中实施,并对具体行业进行针对应用分析,在如何解决可信人工智能监管难题和AI可信决策的度量和标准化等方面对AI可信决策实践具有指导意义。一方面,随着AI不断深入决策制定过程,需要在各种组织内建立高效可信的人机协同团队,并且合理协调跨组织层级智能决策的人机权力分配;另一方面,应该对人工智能决策做出适当的监管,建立配套的度量和标准化管理方案,在提升AI商业价值和保护公众利益之间达成平衡,充分考虑不同决策类型、应用场景、风险等级的具体要求。

【原文引用】

孔祥维,王子明,王明征,胡祥培.人工智能使能系统的可信决策:进展与挑战.管理工程学报,2022,36(6):1-14. DOI:10.13587/j.cnki.jieem.2022.06.001.

来源:管理工程学报

撰文:孔祥维 王子明 王明征 胡祥培

原文编辑:韩敏 杜健

编辑:陈思夏

审核:郭莹